✅ 문제 81

A solutions architect is designing the cloud architecture for a new application being deployed on AWS. The process should run in parallel while adding and removing application nodes as needed based on the number of jobs to be processed. The processor application is stateless. The solutions architect must ensure that the application is loosely coupled and the job items are durably stored.

Which design should the solutions architect use?

솔루션 설계자는 AWS에 배포되는 새 애플리케이션을 위한 클라우드 아키텍처를 설계하고 있습니다. 처리할 작업 수에 따라 필요에 따라 애플리케이션 노드를 추가 및 제거하면서 프로세스가 병렬로 실행되어야 합니다. 프로세서 응용 프로그램은 상태 비저장입니다. 솔루션 설계자는 응용 프로그램이 느슨하게 연결되어 있고 작업 항목이 영구적으로 저장되어 있는지 확인해야 합니다.

솔루션 설계자는 어떤 디자인을 사용해야 합니까?

A.

Create an Amazon SNS topic to send the jobs that need to be processed. Create an Amazon Machine Image (AMI) that consists of the processor application. Create a launch configuration that uses the AMI. Create an Auto Scaling group using the launch configuration. Set the scaling policy for the Auto Scaling group to add and remove nodes based on CPU usage.

처리해야 하는 작업을 보낼 Amazon SNS 주제를 생성합니다. 프로세서 애플리케이션으로 구성된 Amazon 머신 이미지(AMI)를 생성합니다. AMI를 사용하는 시작 구성을 생성합니다. 시작 구성을 사용하여 Auto Scaling 그룹을 생성합니다. CPU 사용량에 따라 노드를 추가 및 제거하도록 Auto Scaling 그룹에 대한 조정 정책을 설정합니다.

B.

Create an Amazon SQS queue to hold the jobs that need to be processed. Create an Amazon Machine Image (AMI) that consists of the processor application. Create a launch configuration that uses the AMI. Create an Auto Scaling group using the launch configuration. Set the scaling policy for the Auto Scaling group to add and remove nodes based on network usage.

처리해야 하는 작업을 보관할 Amazon SQS 대기열을 생성합니다. 프로세서 애플리케이션으로 구성된 Amazon 머신 이미지(AMI)를 생성합니다. AMI를 사용하는 시작 구성을 생성합니다. 시작 구성을 사용하여 Auto Scaling 그룹을 생성합니다. Auto Scaling 그룹의 조정 정책을 설정하여 네트워크 사용량에 따라 노드를 추가 및 제거합니다.

C.

Create an Amazon SQS queue to hold the jobs that need to be processed. Create an Amazon Machine Image (AMI) that consists of the processor application. Create a launch template that uses the AMI. Create an Auto Scaling group using the launch template. Set the scaling policy for the Auto Scaling group to add and remove nodes based on the number of items in the SQS queue.

처리해야 하는 작업을 보관할 Amazon SQS 대기열을 생성합니다. 프로세서 애플리케이션으로 구성된 Amazon 머신 이미지(AMI)를 생성합니다. AMI를 사용하는 시작 템플릿을 생성합니다. 시작 템플릿을 사용하여 Auto Scaling 그룹을 생성합니다. SQS 대기열의 항목 수에 따라 노드를 추가 및 제거하도록 Auto Scaling 그룹에 대한 조정 정책을 설정합니다.

D.

Create an Amazon SNS topic to send the jobs that need to be processed. Create an Amazon Machine Image (AMI) that consists of the processor application. Create a launch template that uses the AMI. Create an Auto Scaling group using the launch template. Set the scaling policy for the Auto Scaling group to add and remove nodes based on the number of messages published to the SNS topic.

처리해야 하는 작업을 보낼 Amazon SNS 주제를 생성합니다. 프로세서 애플리케이션으로 구성된 Amazon 머신 이미지(AMI)를 생성합니다. AMI를 사용하는 시작 템플릿을 생성합니다. 시작 템플릿을 사용하여 Auto Scaling 그룹을 생성합니다. SNS 주제에 게시된 메시지 수에 따라 노드를 추가 및 제거하도록 Auto Scaling 그룹에 대한 조정 정책을 설정합니다.

⭕ 정답: C

📝 해설

Amazon SQS와 Auto Scaling을 사용하여 상태 비저장 애플리케이션을 설계하는 것은 다음과 같은 이유로 가장 적합합니다:

- 느슨한 결합: SQS 대기열을 사용하면 작업 항목을 비동기적으로 처리할 수 있습니다. 이는 애플리케이션 노드 간의 느슨한 결합을 보장합니다.

- 확장성: Auto Scaling 그룹은 SQS 대기열의 작업 항목 수에 따라 노드를 자동으로 추가 및 제거하여 확장성을 제공합니다. 시작 템플릿을 사용하면 AMI를 기반으로 한 인스턴스 구성을 표준화할 수 있습니다.

- 내구성: SQS는 작업 항목을 영구적으로 저장하여 데이터 손실을 방지합니다.

오답 분석:

- A: SNS는 대기열 메시징을 지원하지 않으며, 상태 비저장 작업 처리에 적합하지 않습니다.

- B: 네트워크 사용량 기반으로 Auto Scaling을 설정하는 것은 작업 항목 수를 기반으로 한 확장성 제공에 비효율적입니다.

- D: SNS를 사용하면 메시지의 영구 저장이 보장되지 않습니다.

✅ 문제 82

A company hosts its web applications in the AWS Cloud. The company configures Elastic Load Balancers to use certificates that are imported into AWS Certificate Manager (ACM). The company's security team must be notified 30 days before the expiration of each certificate.

What should a solutions architect recommend to meet this requirement?

회사는 AWS 클라우드에서 웹 애플리케이션을 호스팅합니다. 회사는 AWS Certificate Manager(ACM)로 가져온 인증서를 사용하도록 Elastic Load Balancer를 구성합니다. 각 인증서가 만료되기 30일 전에 회사 보안팀에 알려야 합니다.

솔루션 설계자는 이 요구 사항을 충족하기 위해 무엇을 권장해야 합니까?

A.

Add a rule in ACM to publish a custom message to an Amazon Simple Notification Service (Amazon SNS) topic every day, beginning 30 days before any certificate will expire.

ACM에 규칙을 추가하여 인증서가 만료되기 30일 전부터 매일 Amazon Simple Notification Service(Amazon SNS) 주제에 사용자 지정 메시지를 게시합니다.

B.

Create an AWS Config rule that checks for certificates that will expire within 30 days. Configure Amazon EventBridge (Amazon CloudWatch Events) to invoke a custom alert by way of Amazon Simple Notification Service (Amazon SNS) when AWS Config reports a noncompliant resource.

30일 이내에 만료되는 인증서를 확인하는 AWS Config 규칙을 생성합니다. AWS Config가 비준수 리소스를 보고할 때 Amazon Simple Notification Service(Amazon SNS)를 통해 사용자 지정 알림을 호출하도록 Amazon EventBridge(Amazon CloudWatch Events)를 구성합니다.

C.

Use AWS Trusted Advisor to check for certificates that will expire within 30 days. Create an Amazon CloudWatch alarm that is based on Trusted Advisor metrics for check status changes. Configure the alarm to send a custom alert by way of Amazon Simple Notification Service (Amazon SNS).

AWS Trusted Advisor를 사용하여 30일 이내에 만료되는 인증서를 확인합니다. 상태 변경 확인에 대한 Trusted Advisor 지표를 기반으로 하는 Amazon CloudWatch 경보를 생성합니다. Amazon Simple Notification Service(Amazon SNS)를 통해 사용자 지정 알림을 보내도록 경보를 구성합니다.

D.

Create an Amazon EventBridge (Amazon CloudWatch Events) rule to detect any certificates that will expire within 30 days. Configure the rule to invoke an AWS Lambda function. Configure the Lambda function to send a custom alert by way of Amazon Simple Notification Service (Amazon SNS).

30일 이내에 만료되는 모든 인증서를 감지하는 Amazon EventBridge(Amazon CloudWatch Events) 규칙을 생성합니다. AWS Lambda 함수를 호출하도록 규칙을 구성합니다. Amazon Simple Notification Service(Amazon SNS)를 통해 사용자 지정 알림을 보내도록 Lambda 함수를 구성합니다.

⭕ 정답: B

📝 해설

AWS Config와 Amazon EventBridge를 사용하여 인증서 만료 알림을 설정하는 방법은 다음과 같습니다:

- 자동 모니터링: AWS Config 규칙을 사용하여 인증서의 만료 상태를 모니터링합니다. 규칙이 비준수 리소스를 보고하면 EventBridge를 통해 알림을 트리거합니다.

- 알림 설정: Amazon Simple Notification Service(SNS)를 사용하여 보안팀에 알림을 보낼 수 있습니다.

- 비용 효율성: 추가적인 서버나 복잡한 스크립트를 사용할 필요 없이 AWS에서 제공하는 관리형 서비스를 사용하여 요구 사항을 충족합니다.

오답 분석:

- A: ACM 자체에서 직접 알림을 설정할 수는 없습니다.

- C: Trusted Advisor는 특정한 지표에 대해 추가적인 비용이 발생할 수 있으며, 알림 설정이 복잡합니다.

- D: EventBridge와 Lambda를 사용하는 방법은 가능하지만, AWS Config를 사용하는 것이 더 간단하고 직접적입니다.

✅ 문제 83

A company's dynamic website is hosted using on-premises servers in the United States. The company is launching its product in Europe, and it wants to optimize site loading times for new European users. The site's backend must remain in the United States. The product is being launched in a few days, and an immediate solution is needed.

What should the solutions architect recommend?

회사의 동적 웹 사이트는 미국의 온프레미스 서버를 사용하여 호스팅됩니다. 이 회사는 유럽에서 제품을 출시하고 있으며 새로운 유럽 사용자를 위해 사이트 로딩 시간을 최적화하려고 합니다. 사이트의 백엔드는 미국에 있어야 합니다. 제품이 며칠 안에 출시되며 즉각적인 솔루션이 필요합니다.

솔루션 설계자는 무엇을 권장해야 합니까?

A.

Launch an Amazon EC2 instance in us-east-1 and migrate the site to it.

us-east-1에서 Amazon EC2 인스턴스를 시작하고 사이트를 마이그레이션합니다.

B.

Move the website to Amazon S3. Use Cross-Region Replication between Regions.

웹사이트를 Amazon S3로 이동합니다. 지역 간 교차 지역 복제를 사용합니다.

C.

Use Amazon CloudFront with a custom origin pointing to the on-premises servers.

온프레미스 서버를 가리키는 사용자 지정 오리진과 함께 Amazon CloudFront를 사용합니다.

D.

Use an Amazon Route 53 geoproximity routing policy pointing to on-premises servers.

온프레미스 서버를 가리키는 Amazon Route 53 지리 근접 라우팅 정책을 사용합니다.

⭕ 정답: C

📝 해설

Amazon CloudFront를 사용하여 콘텐츠 전송 네트워크(CDN)를 구성하면 다음과 같은 이점이 있습니다:

- 저지연성: CloudFront는 전 세계적으로 분산된 엣지 로케이션을 사용하여 사용자에게 더 가까운 서버에서 콘텐츠를 제공합니다. 유럽 사용자는 미국 서버에 직접 접속할 필요 없이 가까운 엣지 로케이션에서 콘텐츠를 받을 수 있습니다.

- 쉬운 설정: 온프레미스 서버를 오리진으로 설정하여 빠르게 구성할 수 있습니다. 몇 분 내에 설정을 완료하고 트래픽을 리디렉션할 수 있습니다.

- 비용 효율성: 기존 인프라를 활용하면서 성능을 최적화할 수 있습니다. 초기 설정 비용이 낮고, 사용한 만큼만 비용을 지불합니다.

오답 분석:

- A: EC2 인스턴스를 사용하는 것은 설정 시간이 더 많이 소요되며, 기존 온프레미스 인프라를 활용하지 못합니다.

- B: S3로 이동하는 것은 시간이 많이 걸리며, 동적 콘텐츠 처리에 적합하지 않습니다.

- D: Route 53 지리 근접 라우팅 정책은 트래픽을 지리적으로 라우팅하는 데는 적합하지만, 콘텐츠 전송 네트워크(CDN) 역할을 하지 않습니다.

✅ 문제 84

A company wants to reduce the cost of its existing three-tier web architecture. The web, application, and database servers are running on Amazon EC2 instances for the development, test, and production environments. The EC2 instances average 30% CPU utilization during peak hours and 10% CPU utilization during non-peak hours.

The production EC2 instances run 24 hours a day. The development and test EC2 instances run for at least 8 hours each day. The company plans to implement automation to stop the development and test EC2 instances when they are not in use.

Which EC2 instance purchasing solution will meet the company's requirements MOST cost-effectively?

회사는 기존 3계층 웹 아키텍처의 비용을 절감하려고 합니다. 웹, 애플리케이션 및 데이터베이스 서버는 개발, 테스트 및 프로덕션 환경을 위한 Amazon EC2 인스턴스에서 실행됩니다. EC2 인스턴스의 평균 CPU 사용률은 사용량이 많은 시간에는 30%이고 사용량이 많지 않은 시간에는 10%입니다.

프로덕션 EC2 인스턴스는 하루 24시간 실행됩니다. 개발 및 테스트 EC2 인스턴스는 매일 최소 8시간 동안 실행됩니다. 회사는 개발을 중지하고 사용하지 않을 때 EC2 인스턴스를 테스트하는 자동화를 구현할 계획입니다.

어떤 EC2 인스턴스 구매 솔루션이 가장 비용 효율적으로 회사의 요구 사항을 충족합니까?

A.

Use Spot Instances for the production EC2 instances. Use Reserved Instances for the development and test EC2 instances.

프로덕션 EC2 인스턴스에 스팟 인스턴스를 사용합니다. EC2 인스턴스 개발 및 테스트에 예약 인스턴스를 사용합니다.

B.

Use Reserved Instances for the production EC2 instances. Use On-Demand Instances for the development and test EC2 instances.

프로덕션 EC2 인스턴스에 예약 인스턴스를 사용합니다. 개발 및 테스트 EC2 인스턴스에 온디맨드 인스턴스를 사용합니다.

C.

Use Spot blocks for the production EC2 instances. Use Reserved Instances for the development and test EC2 instances.

프로덕션 EC2 인스턴스에 스팟 블록을 사용합니다. EC2 인스턴스 개발 및 테스트에 예약 인스턴스를 사용합니다.

D.

Use On-Demand Instances for the production EC2 instances. Use Spot blocks for the development and test EC2 instances.

프로덕션 EC2 인스턴스에 온디맨드 인스턴스를 사용합니다. 개발 및 테스트 EC2 인스턴스에 스팟 블록을 사용합니다.

⭕ 정답: B

📝 해설

예약 인스턴스와 온디맨드 인스턴스를 조합하여 비용 효율성을 극대화할 수 있습니다:

- 프로덕션 인스턴스: 예약 인스턴스를 사용하면 장기적으로 비용을 절감할 수 있습니다. 24시간 운영되므로 예약 인스턴스가 적합합니다.

- 개발 및 테스트 인스턴스: 온디맨드 인스턴스를 사용하면 필요할 때만 비용이 발생하므로, 사용량이 일정하지 않은 개발 및 테스트 환경에 적합합니다. 자동화를 통해 사용하지 않을 때 인스턴스를 중지하여 추가적인 비용 절감이 가능합니다.

오답 분석:

- A: 스팟 인스턴스는 예측할 수 없는 종료가 발생할 수 있어 프로덕션 환경에 적합하지 않습니다.

- C: 스팟 블록은 일시적인 작업에 적합하지만, 프로덕션 환경에는 안정성이 부족합니다.

- D: 프로덕션 인스턴스에 온디맨드를 사용하는 것은 비용이 많이 들 수 있습니다.

✅ 문제 85

A company has a production web application in which users upload documents through a web interface or a mobile app. According to a new regulatory requirement. new documents cannot be modified or deleted after they are stored.

What should a solutions architect do to meet this requirement?

회사에 사용자가 웹 인터페이스 또는 모바일 앱을 통해 문서를 업로드하는 프로덕션 웹 애플리케이션이 있습니다. 새로운 규제 요구 사항에 따라 새 문서는 저장 후에 수정하거나 삭제할 수 없습니다.

솔루션 설계자는 이 요구 사항을 충족하기 위해 무엇을 해야 합니까?

A.

Store the uploaded documents in an Amazon S3 bucket with S3 Versioning and S3 Object Lock enabled.

업로드된 문서를 S3 버전 관리 및 S3 객체 잠금이 활성화된 Amazon S3 버킷에 저장합니다.

B.

Store the uploaded documents in an Amazon S3 bucket. Configure an S3 Lifecycle policy to archive the documents periodically.

업로드된 문서를 Amazon S3 버킷에 저장합니다. 문서를 주기적으로 보관하도록 S3 수명 주기 정책을 구성합니다.

C.

Store the uploaded documents in an Amazon S3 bucket with S3 Versioning enabled. Configure an ACL to restrict all access to read-only.

업로드된 문서를 S3 버전 관리가 활성화된 Amazon S3 버킷에 저장합니다. 모든 액세스를 읽기 전용으로 제한하도록 ACL을 구성합니다.

D.

Store the uploaded documents on an Amazon Elastic File System (Amazon EFS) volume. Access the data by mounting the volume in read-only mode.

업로드된 문서를 Amazon Elastic File System(Amazon EFS) 볼륨에 저장합니다. 읽기 전용 모드에서 볼륨을 마운트하여 데이터에 액세스합니다.

⭕ 정답: A

📝 해설

S3 버전 관리와 객체 잠금을 사용하면 데이터의 무결성과 변경 불가능성을 보장할 수 있습니다:

- S3 버전 관리: 모든 버전의 객체를 저장하여, 실수로 삭제하거나 변경된 경우에도 데이터를 보호합니다.

- S3 객체 잠금: 규정 준수 모드에서 객체 잠금을 활성화하면, 특정 기간 동안 객체를 변경하거나 삭제할 수 없습니다. 법적 및 규제 요구 사항을 충족하는 데 도움이 됩니다.

- 보안 및 무결성: 데이터의 변경 및 삭제를 방지하여 중요한 문서를 보호할 수 있습니다.

오답 분석:

C: ACL(액세스 제어 목록)로 버킷과 객체에 대한 액세스를 관리합니다. 각 버킷과 객체마다 하위 리소스로서 연결되어 있는 ACL이 있으며, ACL은 액세스를 허용할 AWS 계정이나 그룹과 액세스 유형을 정의합니다. 리소스에 대한 요청을 수신하면, Amazon S3는 해당 ACL을 확인해 요청자가 필요한 액세스 권한을 보유하고 있는지 판단합니다. Amazon S3의 최신 사용 사례 대부분은 더 이상 ACL을 사용할 필요가 없으며, 각 객체에 대해 액세스를 개별적으로 제어해야 하는 비정상적인 상황을 제외하고는 ACL을 사용 중지하는 것이 좋습니다.

✅ 문제 86

A company has several web servers that need to frequently access a common Amazon RDS MySQL Multi-AZ DB instance. The company wants a secure method for the web servers to connect to the database while meeting a security requirement to rotate user credentials frequently.

Which solution meets these requirements?

회사에는 공통 Amazon RDS MySQL 다중 AZ DB 인스턴스에 자주 액세스해야 하는 여러 웹 서버가 있습니다. 회사는 사용자 자격 증명을 자주 교체해야 하는 보안 요구 사항을 충족하면서 웹 서버가 데이터베이스에 연결할 수 있는 안전한 방법을 원합니다.

어떤 솔루션이 이러한 요구 사항을 충족합니까?

A.

Store the database user credentials in AWS Secrets Manager. Grant the necessary IAM permissions to allow the web servers to access AWS Secrets Manager.

AWS Secrets Manager에 데이터베이스 사용자 자격 증명을 저장합니다. 웹 서버가 AWS Secrets Manager에 액세스할 수 있도록 필요한 IAM 권한을 부여합니다.

B.

Store the database user credentials in AWS Systems Manager OpsCenter. Grant the necessary IAM permissions to allow the web servers to access OpsCenter.

AWS Systems Manager OpsCenter에 데이터베이스 사용자 자격 증명을 저장합니다. 웹 서버가 OpsCenter에 액세스할 수 있도록 필요한 IAM 권한을 부여합니다.

C.

Store the database user credentials in a secure Amazon S3 bucket. Grant the necessary IAM permissions to allow the web servers to retrieve credentials and access the database.

안전한 Amazon S3 버킷에 데이터베이스 사용자 자격 증명을 저장합니다. 웹 서버가 자격 증명을 검색하고 데이터베이스에 액세스할 수 있도록 필요한 IAM 권한을 부여합니다.

D.

Store the database user credentials in files encrypted with AWS Key Management Service (AWS KMS) on the web server file system. The web server should be able to decrypt the files and access the database.

웹 서버 파일 시스템의 AWS Key Management Service(AWS KMS)로 암호화된 파일에 데이터베이스 사용자 자격 증명을 저장합니다. 웹 서버는 파일을 해독하고 데이터베이스에 액세스할 수 있어야 합니다.

⭕ 정답: A

📝 해설

AWS Secrets Manager는 자격 증명을 안전하게 저장하고 자동으로 순환할 수 있는 기능을 제공합니다. 이를 통해 다음과 같은 이점을 얻을 수 있습니다:

- 보안: AWS Secrets Manager는 자격 증명을 안전하게 저장하고 관리합니다. 이를 통해 민감한 정보의 노출을 방지할 수 있습니다. IAM 권한을 통해 웹 서버가 필요한 자격 증명에만 액세스할 수 있도록 제어할 수 있습니다.

- 자동 순환: Secrets Manager는 자격 증명을 자동으로 순환하여 보안 요구 사항을 충족할 수 있습니다. 자격 증명의 수동 관리 부담을 줄일 수 있습니다.

- 통합: Secrets Manager는 다양한 AWS 서비스와 통합되어 쉽게 사용할 수 있습니다.

오답 분석:

- B: OpsCenter는 주로 운영 문제 해결을 위한 도구로 자격 증명 관리를 위한 적절한 솔루션이 아닙니다.

- C: S3 버킷에 자격 증명을 저장하는 것은 보안 위험이 높으며, 자동 자격 증명 순환 기능을 제공하지 않습니다.

- D: KMS로 암호화된 파일을 사용하면 보안은 보장되지만, 자격 증명의 자동 순환 및 관리가 어려워집니다.

✅ 문제 87

A company hosts an application on AWS Lambda functions that are invoked by an Amazon API Gateway API. The Lambda functions save customer data to an Amazon Aurora MySQL database. Whenever the company upgrades the database, the Lambda functions fail to establish database connections until the upgrade is complete. The result is that customer data is not recorded for some of the event.

A solutions architect needs to design a solution that stores customer data that is created during database upgrades.

Which solution will meet these requirements?

회사는 Amazon API Gateway API에 의해 호출되는 AWS Lambda 함수에서 애플리케이션을 호스팅합니다. Lambda 함수는 고객 데이터를 Amazon Aurora MySQL 데이터베이스에 저장합니다. 회사에서 데이터베이스를 업그레이드할 때마다 Lambda 함수는 업그레이드가 완료될 때까지 데이터베이스 연결을 설정하지 못합니다. 그 결과 일부 이벤트에 대한 고객 데이터가 기록되지 않습니다.

솔루션 설계자는 데이터베이스 업그레이드 중에 생성되는 고객 데이터를 저장하는 솔루션을 설계해야 합니다. 어떤 솔루션이 이러한 요구 사항을 충족합니까?

A.

Provision an Amazon RDS proxy to sit between the Lambda functions and the database. Configure the Lambda functions to connect to the RDS proxy.

Lambda 함수와 데이터베이스 사이에 위치하도록 Amazon RDS 프록시를 프로비저닝합니다. RDS 프록시에 연결하도록 Lambda 함수를 구성합니다.

B.

Increase the run time of the Lambda functions to the maximum. Create a retry mechanism in the code that stores the customer data in the database.

Lambda 함수의 실행 시간을 최대로 늘립니다. 데이터베이스에 고객 데이터를 저장하는 코드에서 재시도 메커니즘을 만듭니다.

C.

Persist the customer data to Lambda local storage. Configure new Lambda functions to scan the local storage to save the customer data to the database.

고객 데이터를 Lambda 로컬 스토리지에 유지합니다. 고객 데이터를 데이터베이스에 저장하기 위해 로컬 스토리지를 스캔하도록 새로운 Lambda 함수를 구성합니다.

D.

Store the customer data in an Amazon Simple Queue Service (Amazon SQS) FIFO queue. Create a new Lambda function that polls the queue and stores the customer data in the database.

Amazon Simple Queue Service(Amazon SQS) FIFO 대기열에 고객 데이터를 저장합니다. 대기열을 폴링하고 고객 데이터를 데이터베이스에 저장하는 새 Lambda 함수를 생성합니다.

⭕ 정답: D

📝 해설

SQS FIFO 대기열을 사용하여 데이터베이스 업그레이드 동안 데이터를 일시적으로 저장하면 다음과 같은 이점을 얻을 수 있습니다:

- 데이터 손실 방지: SQS FIFO 대기열은 메시지의 순서를 유지하고 중복 처리를 방지합니다. 이를 통해 데이터 손실 없이 데이터를 일시적으로 저장할 수 있습니다.

- 내구성: SQS는 데이터를 안전하게 저장하여 데이터베이스가 업그레이드되는 동안 데이터를 보존할 수 있습니다.

- 확장성: Lambda 함수가 대기열을 폴링하여 데이터베이스가 사용 가능해지면 데이터를 처리할 수 있도록 설정할 수 있습니다.

오답 분석:

- A: RDS 프록시는 데이터베이스 연결 풀링을 제공하지만, 데이터베이스가 업그레이드 중일 때 문제를 해결하지 못합니다.

- B: Lambda 함수의 실행 시간을 늘리는 것은 근본적인 문제를 해결하지 못하며, 재시도 메커니즘은 일시적인 해결책에 불과합니다.

- C: Lambda 로컬 스토리지는 데이터베이스 업그레이드 동안 데이터를 일시적으로 저장하기에 적절한 내구성을 제공하지 않습니다.

✅ 문제 88

A survey company has gathered data for several years from areas in the United States. The company hosts the data in an Amazon S3 bucket that is 3 TB in size and growing. The company has started to share the data with a European marketing firm that has S3 buckets. The company wants to ensure that its data transfer costs remain as low as possible.

Which solution will meet these requirements?

설문 조사 회사는 미국 지역에서 수년 동안 데이터를 수집했습니다. 이 회사는 크기가 3TB이고 계속 증가하는 Amazon S3 버킷에 데이터를 호스팅합니다. 이 회사는 S3 버킷이 있는 유럽 마케팅 회사와 데이터를 공유하기 시작했습니다. 회사는 데이터 전송 비용이 가능한 한 낮게 유지되기를 원합니다.

어떤 솔루션이 이러한 요구 사항을 충족합니까?

A.

Configure the Requester Pays feature on the company's S3 bucket.

회사의 S3 버킷에서 요청자 지불 기능을 구성합니다.

B.

Configure S3 Cross-Region Replication from the company's S3 bucket to one of the marketing firm's S3 buckets.

회사의 S3 버킷에서 마케팅 회사의 S3 버킷 중 하나로 S3 교차 리전 복제를 구성합니다.

C.

Configure cross-account access for the marketing firm so that the marketing firm has access to the company's S3 bucket.

마케팅 회사가 회사의 S3 버킷에 액세스할 수 있도록 마케팅 회사에 대한 교차 계정 액세스를 구성합니다.

D.

Configure the company's S3 bucket to use S3 Intelligent-Tiering. Sync the S3 bucket to one of the marketing firm's S3 buckets.

S3 Intelligent-Tiering을 사용하도록 회사의 S3 버킷을 구성합니다. S3 버킷을 마케팅 회사의 S3 버킷 중 하나와 동기화합니다.

⭕ 정답: B

📝 해설

S3 교차 리전 복제(CRR)를 사용하면 데이터 전송 비용을 절감하면서 유럽의 마케팅 회사와 데이터를 공유할 수 있습니다:

- 비용 효율성: CRR을 사용하면 데이터 전송 비용을 절감할 수 있습니다. 요청자 지불 모델을 사용할 때보다 비용 효율적입니다.

- 데이터 접근성: 데이터가 유럽의 S3 버킷에 복제되므로 마케팅 회사는 데이터를 직접 액세스할 수 있습니다.

- 보안: S3의 기본 보안 기능을 통해 데이터가 안전하게 전송 및 저장됩니다.

오답 분석:

- A: 요청자 지불 기능은 비용을 전가할 수 있지만, 데이터 전송 비용을 완전히 제거하지는 않습니다.

- C: 교차 계정 액세스는 데이터 전송 비용을 줄이지 못합니다.

- D: S3 Intelligent-Tiering은 스토리지 비용 최적화에는 도움이 되지만, 데이터 전송 비용 절감에는 도움이 되지 않습니다.

✅ 문제 89

A company uses Amazon S3 to store its confidential audit documents. The S3 bucket uses bucket policies to restrict access to audit team IAM user credentials according to the principle of least privilege. Company managers are worried about accidental deletion of documents in the S3 bucket and want a more secure solution.

What should a solutions architect do to secure the audit documents?

회사는 Amazon S3를 사용하여 기밀 감사 문서를 저장합니다. S3 버킷은 버킷 정책을 사용하여 최소 권한 원칙에 따라 감사 팀 IAM 사용자 자격 증명에 대한 액세스를 제한합니다. 회사 관리자는 S3 버킷에서 실수로 문서가 삭제되는 것을 걱정하고 더 안전한 솔루션을 원합니다.

솔루션 설계자는 감사 문서를 보호하기 위해 무엇을 해야 합니까?

A.

Enable the versioning and MFA Delete features on the S3 bucket.

S3 버킷에서 버전 관리 및 MFA 삭제 기능을 활성화합니다.

B.

Enable multi-factor authentication (MFA) on the IAM user credentials for each audit team IAM user account.

각 감사 팀 IAM 사용자 계정의 IAM 사용자 자격 증명에 대해 다단계 인증(MFA)을 활성화합니다.

C.

Add an S3 Lifecycle policy to the audit team's IAM user accounts to deny the s3:DeleteObject action during audit dates.

감사 날짜 동안 s3:DeleteObject 작업을 거부하도록 감사 팀의 IAM 사용자 계정에 S3 수명 주기 정책을 추가합니다.

D.

Use AWS Key Management Service (AWS KMS) to encrypt the S3 bucket and restrict audit team IAM user accounts from accessing the KMS key.

AWS Key Management Service(AWS KMS)를 사용하여 S3 버킷을 암호화하고 감사 팀 IAM 사용자 계정이 KMS 키에 액세스하지 못하도록 제한합니다.

⭕ 정답: A

📝 해설

S3 버전 관리와 MFA 삭제 기능을 사용하면 문서의 무결성과 보안을 강화할 수 있습니다:

- 버전 관리: 버전 관리를 활성화하면 객체의 모든 버전을 유지하여 실수로 삭제된 파일을 복구할 수 있습니다.

- MFA 삭제: MFA 삭제를 활성화하면 삭제 작업을 수행하려면 다단계 인증이 필요하므로 실수로 인한 삭제를 방지할 수 있습니다.

오답 분석:

- B: IAM 사용자 자격 증명에 MFA를 적용하는 것은 접근 보안을 강화하지만, 삭제 방지에는 직접적인 도움이 되지 않습니다.

- C: 수명 주기 정책은 삭제 방지를 보장하지 않습니다.

- D: KMS 암호화는 데이터 보안을 강화하지만, 삭제 방지에는 적절하지 않습니다.

✅ 문제 90

A company is using a SQL database to store movie data that is publicly accessible. The database runs on an Amazon RDS Single-AZ DB instance. A script runs queries at random intervals each day to record the number of new movies that have been added to the database. The script must report a final total during business hours.

The company's development team notices that the database performance is inadequate for development tasks when the script is running. A solutions architect must recommend a solution to resolve this issue.

Which solution will meet this requirement with the LEAST operational overhead?

회사에서 SQL 데이터베이스를 사용하여 공개적으로 액세스할 수 있는 영화 데이터를 저장하고 있습니다. 데이터베이스는 Amazon RDS 단일 AZ DB 인스턴스에서 실행됩니다. 스크립트는 데이터베이스에 추가된 새로운 영화의 수를 기록하기 위해 매일 임의의 간격으로 쿼리를 실행합니다. 스크립트는 업무 시간 동안의 최종 합계를 보고해야 합니다.

회사의 개발 팀은 스크립트가 실행 중일 때 데이터베이스 성능이 개발 작업에 부적절하다는 것을 알아차렸습니다. 솔루션 설계자는 이 문제를 해결하기 위한 솔루션을 권장해야 합니다.

최소한의 운영 오버헤드로 이 요구 사항을 충족하는 솔루션은 무엇입니까?

A.

Modify the DB instance to be a Multi-AZ deployment.

DB 인스턴스를 다중 AZ 배포로 수정합니다.

B.

Create a read replica of the database. Configure the script to query only the read replica.

데이터베이스의 읽기 전용 복제본을 생성합니다. 읽기 전용 복제본만 쿼리하도록 스크립트를 구성합니다.

C.

Instruct the development team to manually export the entries in the database at the end of each day.

개발 팀에게 매일 일과가 끝날 때 데이터베이스의 항목을 수동으로 내보내도록 지시합니다.

D.

Use Amazon ElastiCache to cache the common queries that the script runs against the database.

Amazon ElastiCache를 사용하여 스크립트가 데이터베이스에 대해 실행하는 일반적인 쿼리를 캐시합니다.

⭕ 정답: B

📝 해설

읽기 전용 복제본을 사용하면 데이터베이스 성능을 최적화하면서 쿼리를 분산할 수 있습니다:

- 부하 분산: 읽기 전용 복제본을 사용하면 주요 데이터베이스 인스턴스의 부하를 줄이고, 읽기 작업을 복제본으로 분산할 수 있습니다.

- 성능 최적화: 스크립트가 읽기 전용 복제본을 쿼리하도록 구성하면 주요 인스턴스의 성능 저하를 방지할 수 있습니다.

오답 분석:

- A: 다중 AZ 배포는 고가용성을 제공하지만 성능 문제를 해결하지 못합니다.

- C: 수동 데이터 내보내기는 운영 오버헤드가 크고, 실시간 데이터를 처리하는 데 적합하지 않습니다.

- D: ElastiCache는 캐싱 솔루션으로, 읽기 복제본만큼 효과적으로 데이터베이스 부하를 분산시키지 않습니다.

✅ 문제 91

A company has applications that run on Amazon EC2 instances in a VPC. One of the applications needs to call the Amazon S3 API to store and read objects. According to the company's security regulations, no traffic from the applications is allowed to travel across the internet.

Which solution will meet these requirements?

회사에 VPC의 Amazon EC2 인스턴스에서 실행되는 애플리케이션이 있습니다. 애플리케이션 중 하나는 Amazon S3 API를 호출하여 객체를 저장하고 읽어야 합니다. 회사의 보안 규정에 따라 응용 프로그램의 트래픽은 인터넷을 통해 이동할 수 없습니다.

어떤 솔루션이 이러한 요구 사항을 충족합니까?

A.

Configure an S3 gateway endpoint.

S3 게이트웨이 엔드포인트를 구성합니다.

B.

Create an S3 bucket in a private subnet.

프라이빗 서브넷에 S3 버킷을 생성합니다.

C.

Create an S3 bucket in the same AWS Region as the EC2 instances.

EC2 인스턴스와 동일한 AWS 리전에 S3 버킷을 생성합니다.

D.

Configure a NAT gateway in the same subnet as the EC2 instances.

EC2 인스턴스와 동일한 서브넷에 NAT 게이트웨이를 구성합니다.

⭕ 정답: A

📝 해설

Amazon S3에 대한 게이트웨이 엔드포인트를 사용하면 트래픽이 인터넷을 통하지 않고 안전하게 VPC 내부에서 S3 버킷으로 라우팅됩니다. 이를 통해 보안 규정을 준수하면서도 S3에 대한 액세스를 가능하게 합니다.

오답 분석:

- B: 프라이빗 서브넷에 S3 버킷을 생성하는 것은 불가능합니다. S3는 글로벌 서비스로 퍼블릭 리소스입니다.

- C: 동일한 리전에 S3 버킷을 생성해도 인터넷을 통하지 않는 직접 액세스를 제공하지 않습니다.

- D: NAT 게이트웨이는 인터넷을 통해 트래픽을 라우팅하기 때문에 보안 규정을 준수하지 않습니다.

✅ 문제 92

A company is storing sensitive user information in an Amazon S3 bucket. The company wants to provide secure access to this bucket from the application tier running on Amazon EC2 instances inside a VPC.

Which combination of steps should a solutions architect take to accomplish this? (Choose two.)

회사에서 Amazon S3 버킷에 민감한 사용자 정보를 저장하고 있습니다. 회사는 VPC 내부의 Amazon EC2 인스턴스에서 실행되는 애플리케이션 계층에서 이 버킷에 대한 보안 액세스를 제공하려고 합니다.

솔루션 설계자는 이를 달성하기 위해 어떤 단계 조합을 취해야 합니까? (2개를 선택하세요.)

A.

Configure a VPC gateway endpoint for Amazon S3 within the VPC.

VPC 내에서 Amazon S3용 VPC 게이트웨이 엔드포인트를 구성합니다.

B.

Create a bucket policy to make the objects in the S3 bucket public.

S3 버킷의 객체를 퍼블릭으로 만들기 위한 버킷 정책을 생성합니다.

C.

Create a bucket policy that limits access to only the application tier running in the VPC.

VPC에서 실행되는 애플리케이션 계층으로만 액세스를 제한하는 버킷 정책을 생성합니다.

D.

Create an IAM user with an S3 access policy and copy the IAM credentials to the EC2 instance.

S3 액세스 정책으로 IAM 사용자를 생성하고 IAM 자격 증명을 EC2 인스턴스에 복사합니다.

E.

Create a NAT instance and have the EC2 instances use the NAT instance to access the S3 bucket.

NAT 인스턴스를 생성하고 EC2 인스턴스가 NAT 인스턴스를 사용하여 S3 버킷에 액세스하도록 합니다.

⭕ 정답: A, C

📝 해설

- A: S3 게이트웨이 엔드포인트를 사용하면 트래픽이 인터넷을 통하지 않고 안전하게 VPC 내부에서 S3로 라우팅됩니다.

- C: 버킷 정책을 통해 특정 VPC에서만 액세스할 수 있도록 제한하여 보안을 강화할 수 있습니다.

오답 분석:

- B: 객체를 퍼블릭으로 만드는 것은 보안 위험이 크므로 적절하지 않습니다.

- D: IAM 자격 증명을 EC2 인스턴스에 복사하는 것은 안전하지 않으며 관리가 어렵습니다.

- E: NAT 인스턴스를 사용하는 것은 불필요하게 복잡하며 보안상 위험이 있을 수 있습니다.

✅ 문제 93

A company runs an on-premises application that is powered by a MySQL database. The company is migrating the application to AWS to increase the application's elasticity and availability.

The current architecture shows heavy read activity on the database during times of normal operation. Every 4 hours, the company's development team pulls a full export of the production database to populate a database in the staging environment. During this period, users experience unacceptable application latency. The development team is unable to use the staging environment until the procedure completes.

A solutions architect must recommend replacement architecture that alleviates the application latency issue. The replacement architecture also must give the development team the ability to continue using the staging environment without delay.

Which solution meets these requirements?

회사는 MySQL 데이터베이스로 구동되는 온프레미스 애플리케이션을 실행합니다. 이 회사는 애플리케이션의 탄력성과 가용성을 높이기 위해 애플리케이션을 AWS로 마이그레이션하고 있습니다.

현재 아키텍처는 정상 작동 시간 동안 데이터베이스에서 많은 읽기 활동을 보여줍니다. 회사의 개발 팀은 4시간마다 프로덕션 데이터베이스의 전체 내보내기를 가져와 준비 환경의 데이터베이스를 채웁니다. 이 기간 동안 사용자는 허용할 수 없는 애플리케이션 대기 시간을 경험합니다. 개발 팀은 절차가 완료될 때까지 스테이징 환경을 사용할 수 없습니다.

솔루션 설계자는 애플리케이션 지연 문제를 완화하는 대체 아키텍처를 권장해야 합니다. 또한 대체 아키텍처는 개발 팀이 지연 없이 스테이징 환경을 계속 사용할 수 있는 능력을 제공해야 합니다. 어떤 솔루션이 이러한 요구 사항을 충족합니까?

* 스테이징 환경 : 실제 운영 환경과 거의 동일한 환경으로 만들어놓고 기능을 검증하는 환경.

A.

Use Amazon Aurora MySQL with Multi-AZ Aurora Replicas for production. Populate the staging database by implementing a backup and restore process that uses the mysqldump utility.

프로덕션용 다중 AZ Aurora 복제본과 함께 Amazon Aurora MySQL을 사용합니다. mysqldump 유틸리티를 사용하는 백업 및 복원 프로세스를 구현하여 스테이징 데이터베이스를 채웁니다.

B.

Use Amazon Aurora MySQL with Multi-AZ Aurora Replicas for production. Use database cloning to create the staging database on-demand.

프로덕션용 다중 AZ Aurora 복제본과 함께 Amazon Aurora MySQL을 사용합니다. 데이터베이스 복제를 사용하여 요청 시 스테이징 데이터베이스를 생성합니다.

* 스테이징 : 스테이지(Stage)에 따라 각 단계를 구분하여 프로젝트가 진행되는 것을 스테이징(Staging)이라고 한다.

C.

Use Amazon RDS for MySQL with a Multi-AZ deployment and read replicas for production. Use the standby instance for the staging database.

다중 AZ 배포 및 프로덕션용 읽기 전용 복제본과 함께 MySQL용 Amazon RDS를 사용합니다. 스테이징 데이터베이스에 대해 대기 인스턴스를 사용합니다.

D.

Use Amazon RDS for MySQL with a Multi-AZ deployment and read replicas for production. Populate the staging database by implementing a backup and restore process that uses the mysqldump utility.

다중 AZ 배포 및 프로덕션용 읽기 전용 복제본과 함께 MySQL용 Amazon RDS를 사용합니다. mysqldump 유틸리티를 사용하는 백업 및 복원 프로세스를 구현하여 스테이징 데이터베이스를 채웁니다.

⭕ 정답: B

📝 해설

Amazon Aurora의 데이터베이스 복제 기능을 사용하면 스테이징 환경을 빠르게 생성하고 데이터베이스 성능에 영향을 미치지 않습니다. 이는 개발 팀이 지연 없이 스테이징 환경을 사용할 수 있도록 보장합니다.

오답 분석:

- A: mysqldump 유틸리티를 사용한 백업 및 복원 프로세스는 현재의 문제를 해결하지 못하며 동일한 성능 저하를 야기할 수 있습니다.

- C: 스탠바이 인스턴스를 사용하는 것은 지연 없는 스테이징 환경을 보장하지 않습니다.

- D: 백업 및 복원 프로세스는 여전히 성능 문제를 유발할 수 있습니다.

✅ 문제 94

A company is designing an application where users upload small files into Amazon S3. After a user uploads a file, the file requires one-time simple processing to transform the data and save the data in JSON format for later analysis.

Each file must be processed as quickly as possible after it is uploaded. Demand will vary. On some days, users will upload a high number of files. On other days, users will upload a few files or no files.

Which solution meets these requirements with the LEAST operational overhead?

한 회사에서 사용자가 Amazon S3에 작은 파일을 업로드하는 애플리케이션을 설계하고 있습니다. 사용자가 파일을 업로드한 후 데이터를 변환하고 나중에 분석할 수 있도록 데이터를 JSON 형식으로 저장하려면 파일에 일회성 단순 처리가 필요합니다. 각 파일은 업로드 후 최대한 빨리 처리해야 합니다. 수요는 다양할 것입니다. 어떤 날에는 사용자가 많은 수의 파일을 업로드합니다. 다른 날에는 사용자가 몇 개의 파일을 업로드하거나 파일을 업로드하지 않습니다.

최소한의 운영 오버헤드로 이러한 요구 사항을 충족하는 솔루션은 무엇입니까?

A.

Configure Amazon EMR to read text files from Amazon S3. Run processing scripts to transform the data. Store the resulting JSON file in an Amazon Aurora DB cluster.

Amazon S3에서 텍스트 파일을 읽도록 Amazon EMR을 구성합니다. 처리 스크립트를 실행하여 데이터를 변환합니다. 결과 JSON 파일을 Amazon Aurora DB 클러스터에 저장합니다.

B.

Configure Amazon S3 to send an event notification to an Amazon Simple Queue Service (Amazon SQS) queue. Use Amazon EC2 instances to read from the queue and process the data. Store the resulting JSON file in Amazon DynamoDB.

Amazon SQS(Amazon Simple Queue Service) 대기열에 이벤트 알림을 보내도록 Amazon S3를 구성합니다. Amazon EC2 인스턴스를 사용하여 대기열에서 읽고 데이터를 처리합니다. 결과 JSON 파일을 Amazon DynamoDB에 저장합니다.

C.

Configure Amazon S3 to send an event notification to an Amazon Simple Queue Service (Amazon SQS) queue. Use an AWS Lambda function to read from the queue and process the data. Store the resulting JSON file in Amazon DynamoDB.

이벤트 알림을 Amazon Simple Queue Service(Amazon SQS) 대기열로 보내도록 Amazon S3를 구성합니다. AWS Lambda 함수를 사용하여 대기열에서 읽고 데이터를 처리합니다. 결과 JSON 파일을 Amazon DynamoDB에 저장합니다.

D.

Configure Amazon EventBridge (Amazon CloudWatch Events) to send an event to Amazon Kinesis Data Streams when a new file is uploaded. Use an AWS Lambda function to consume the event from the stream and process the data. Store the resulting JSON file in an Amazon Aurora DB cluster.

새 파일이 업로드될 때 Amazon Kinesis Data Streams에 이벤트를 보내도록 Amazon EventBridge(Amazon CloudWatch Events)를 구성합니다. AWS Lambda 함수를 사용하여 스트림에서 이벤트를 소비하고 데이터를 처리합니다. 결과 JSON 파일을 Amazon Aurora DB 클러스터에 저장합니다.

⭕ 정답: C

📝 해설

AWS Lambda와 SQS를 사용하면 파일 업로드 시 자동으로 처리할 수 있습니다. Lambda 함수는 이벤트 기반으로 실행되어 운영 오버헤드를 최소화하고 DynamoDB에 결과를 저장할 수 있습니다.

오답 분석:

- A: Amazon EMR은 운영 오버헤드가 크고, 작은 파일을 처리하기에는 비효율적입니다.

- B: EC2 인스턴스를 사용하는 것은 운영 및 관리 오버헤드가 큽니다.

- D: Kinesis Data Streams는 작은 파일 처리에는 과도한 솔루션입니다.

✅ 문제 95

An application allows users at a company's headquarters to access product data. The product data is stored in an Amazon RDS MySQL DB instance. The operations team has isolated an application performance slowdown and wants to separate read traffic from write traffic. A solutions architect needs to optimize the application's performance quickly.

What should the solutions architect recommend?

응용 프로그램을 사용하면 회사 본사의 사용자가 제품 데이터에 액세스할 수 있습니다. 제품 데이터는 Amazon RDS MySQL DB 인스턴스에 저장됩니다. 운영 팀은 애플리케이션 성능 저하를 격리하고 쓰기 트래픽에서 읽기 트래픽을 분리하려고 합니다. 솔루션 설계자는 애플리케이션의 성능을 신속하게 최적화해야 합니다.

솔루션 설계자는 무엇을 권장해야 합니까?

A.

Change the existing database to a Multi-AZ deployment. Serve the read requests from the primary Availability Zone.

기존 데이터베이스를 다중 AZ 배포로 변경합니다. 기본 가용 영역에서 읽기 요청을 제공합니다.

B.

Change the existing database to a Multi-AZ deployment. Serve the read requests from the secondary Availability Zone.

기존 데이터베이스를 다중 AZ 배포로 변경합니다. 보조 가용 영역에서 읽기 요청을 제공합니다.

C.

Create read replicas for the database. Configure the read replicas with half of the compute and storage resources as the source database.

데이터베이스에 대한 읽기 전용 복제본을 생성합니다. 컴퓨팅 및 스토리지 리소스의 절반을 원본 데이터베이스로 사용하여 읽기 전용 복제본을 구성합니다.

D.

Create read replicas for the database. Configure the read replicas with the same compute and storage resources as the source database.

데이터베이스에 대한 읽기 전용 복제본을 생성합니다. 원본 데이터베이스와 동일한 컴퓨팅 및 스토리지 리소스로 읽기 전용 복제본을 구성합니다.

⭕ 정답: D

📝 해설

읽기 전용 복제본을 사용하여 읽기 트래픽을 처리하면 성능을 신속하게 최적화할 수 있습니다. 원본 데이터베이스와 동일한 리소스로 구성하면 읽기 성능을 보장할 수 있습니다.

오답 분석:

- A: 다중 AZ 배포는 고가용성을 제공하지만 읽기/쓰기 트래픽 분리 문제를 해결하지 못합니다.

- B: 보조 가용 영역에서 읽기 요청을 제공하는 것은 다중 AZ 배포의 목적에 맞지 않습니다.

- C: 절반의 리소스로 읽기 복제본을 구성하면 성능이 저하될 수 있습니다.

✅ 문제 96

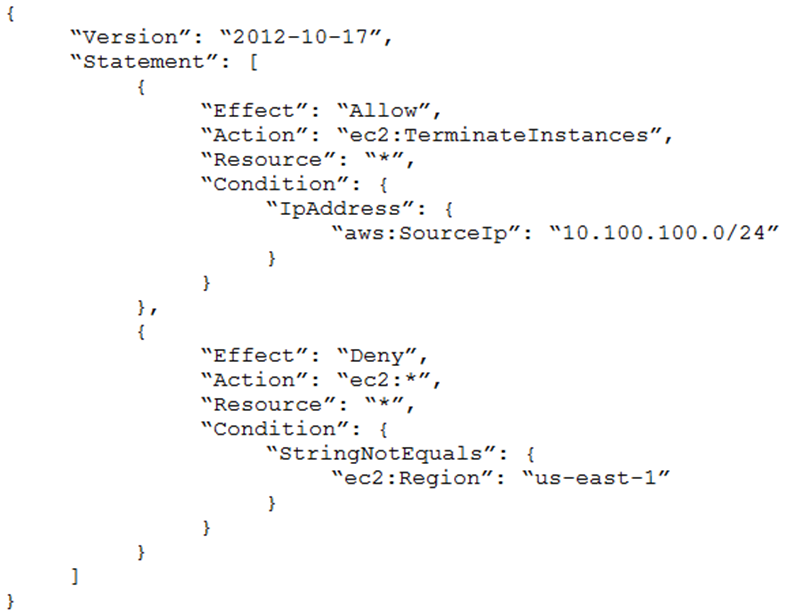

An Amazon EC2 administrator created the following policy associated with an IAM group containing several users:

Amazon EC2 관리자가 여러 사용자를 포함하는 IAM 그룹과 연결된 다음 정책을 생성했습니다.

What is the effect of this policy?

이 정책의 효과는 무엇입니까?

A.

Users can terminate an EC2 instance in any AWS Region except us-east-1.

사용자는 us-east-1을 제외한 모든 AWS 리전에서 EC2 인스턴스를 종료할 수 있습니다.

B.

Users can terminate an EC2 instance with the IP address 10.100.100.1 in the us-east-1 Region.

사용자는 us-east-1 리전에서 IP 주소가 10.100.100.1인 EC2 인스턴스를 종료할 수 있습니다.

C.

Users can terminate an EC2 instance in the us-east-1 Region when the user's source IP is 10.100.100.254.

사용자는 사용자의 소스 IP가 10.100.100.254일 때 us-east-1 리전에서 EC2 인스턴스를 종료할 수 있습니다.

D.

Users cannot terminate an EC2 instance in the us-east-1 Region when the user's source IP is 10.100.100.254.

사용자의 소스 IP가 10.100.100.254인 경우 사용자는 us-east-1 리전에서 EC2 인스턴스를 종료할 수 없습니다.

⭕ 정답: C

📝 해설

📍 정책 분석

- Effect: Allow - 이 정책은 특정 동작을 허용함을 나타냅니다.

- Action: ec2:TerminateInstances - 이는 EC2 인스턴스를 종료하는 동작을 의미합니다.

- Resource: * - 이 정책은 모든 리소스에 적용됩니다.

- Condition:

- StringEquals: "aws:RequestedRegion": "us-east-1" - 이 동작은 us-east-1 리전에서만 허용됩니다.

- IpAddress: "aws:SourceIp": "10.100.100.254" - 이 동작은 요청이 지정된 IP 주소(10.100.100.254)에서 발생할 때만 허용됩니다.

- 거부 정책은 AWS에 따라 항상 허용 정책보다 우선합니다.

- 첫 번째 명령문은 "10.100.100.254" IP 주소 범위에서 오는 ec2 종료 작업을 허용합니다.

- 두 번째 명령문은 ec2에 대한 모든 작업을 거부합니다(StringNotEquals은 AWS에 따른 부정 일치를 의미). 이는 요청이 us-east-1에서 오지 않는 한 ec2에 대한 모든 작업을 거부합니다. 즉, us-east-1에서만 작업을 허용합니다.

- 거부 규칙이 허용 규칙보다 먼저 적용됩니다.

✅ 문제 97

A company has a large Microsoft SharePoint deployment running on-premises that requires Microsoft Windows shared file storage. The company wants to migrate this workload to the AWS Cloud and is considering various storage options. The storage solution must be highly available and integrated with Active Directory for access control.

Which solution will satisfy these requirements?

회사에는 Microsoft Windows 공유 파일 저장소가 필요한 온프레미스에서 실행되는 대규모 Microsoft SharePoint 배포가 있습니다. 회사는 이 워크로드를 AWS 클라우드로 마이그레이션하기를 원하며 다양한 스토리지 옵션을 고려하고 있습니다. 저장소 솔루션은 액세스 제어를 위해 고가용성 및 Active Directory와 통합되어야 합니다.

이러한 요구 사항을 충족하는 솔루션은 무엇입니까?

A.

Configure Amazon EFS storage and set the Active Directory domain for authentication.

Amazon EFS 스토리지를 구성하고 인증을 위해 Active Directory 도메인을 설정합니다.

B.

Create an SMB file share on an AWS Storage Gateway file gateway in two Availability Zones.

두 가용 영역의 AWS Storage Gateway 파일 게이트웨이에 SMB 파일 공유를 생성합니다.

C.

Create an Amazon S3 bucket and configure Microsoft Windows Server to mount it as a volume.

Amazon S3 버킷을 생성하고 볼륨으로 탑재하도록 Microsoft Windows Server를 구성합니다.

D.

Create an Amazon FSx for Windows File Server file system on AWS and set the Active Directory domain for authentication.

AWS에서 Windows 파일 서버용 Amazon FSx 파일 시스템을 생성하고 인증을 위해 Active Directory 도메인을 설정합니다.

⭕ 정답: D

📝 해설

Windows 파일 서버용 Amazon FSx는 완전 관리형 네이티브 Microsoft Windows 파일 시스템을 제공하며, Active Directory와 통합되어 인증 및 접근 제어를 관리할 수 있습니다. 이는 고가용성을 제공하며, SharePoint와 같은 Microsoft 환경에 적합합니다.

주요 용어 설명:

- Amazon FSx for Windows File Server: Microsoft Windows Server와 호환되는 완전 관리형 네이티브 Windows 파일 시스템을 제공하는 서비스입니다.

- Active Directory: 네트워크 리소스의 인증 및 권한 부여를 관리하는 디렉터리 서비스입니다.

오답 분석:

- A: Amazon EFS는 주로 Linux 워크로드에 적합하며, Windows 환경 및 Active Directory 통합에는 적합하지 않습니다.

- B: AWS Storage Gateway는 온프레미스와 클라우드 간의 하이브리드 스토리지 솔루션으로, 완전한 클라우드 기반 솔루션이 아닙니다.

- C: Amazon S3는 객체 저장소로, 파일 시스템 인터페이스가 필요한 SharePoint와는 적합하지 않습니다.

✅ 문제 98

An image-processing company has a web application that users use to upload images. The application uploads the images into an Amazon S3 bucket. The company has set up S3 event notifications to publish the object creation events to an Amazon Simple Queue Service (Amazon SQS) standard queue. The SQS queue serves as the event source for an AWS Lambda function that processes the images and sends the results to users through email.

Users report that they are receiving multiple email messages for every uploaded image. A solutions architect determines that SQS messages are invoking the Lambda function more than once, resulting in multiple email messages.

What should the solutions architect do to resolve this issue with the LEAST operational overhead?

이미지 처리 회사에는 사용자가 이미지를 업로드하는 데 사용하는 웹 응용 프로그램이 있습니다. 애플리케이션은 이미지를 Amazon S3 버킷에 업로드합니다. 회사는 객체 생성 이벤트를 Amazon Simple Queue Service(Amazon SQS) 표준 대기열에 게시하도록 S3 이벤트 알림을 설정했습니다. SQS 대기열은 이미지를 처리하고 결과를 이메일을 통해 사용자에게 보내는 AWS Lambda 함수의 이벤트 소스 역할을 합니다.

사용자는 업로드된 모든 이미지에 대해 여러 이메일 메시지를 수신하고 있다고 보고합니다. 솔루션 설계자는 SQS 메시지가 Lambda 함수를 두 번 이상 호출하여 여러 이메일 메시지를 생성한다고 판단합니다.

솔루션 설계자는 이 문제를 최소한의 운영 오버헤드로 해결하기 위해 무엇을 해야 합니까?

A.

Set up long polling in the SQS queue by increasing the ReceiveMessage wait time to 30 seconds.

ReceiveMessage 대기 시간을 30초로 늘려 SQS 대기열에서 긴 폴링을 설정합니다.

B.

Change the SQS standard queue to an SQS FIFO queue. Use the message deduplication ID to discard duplicate messages.

SQS 표준 대기열을 SQS FIFO 대기열로 변경합니다. 메시지 중복 제거 ID를 사용하여 중복 메시지를 버리십시오.

C.

Increase the visibility timeout in the SQS queue to a value that is greater than the total of the function timeout and the batch window timeout.

SQS 대기열의 가시성 제한 시간을 함수 제한 시간과 일괄 처리 창 제한 시간의 합계보다 큰 값으로 늘립니다.

D.

Modify the Lambda function to delete each message from the SQS queue immediately after the message is read before processing.

처리 전에 메시지를 읽은 직후 SQS 대기열에서 각 메시지를 삭제하도록 Lambda 함수를 수정합니다.

⭕ 정답: C

📝 해설

SQS 대기열의 가시성 제한 시간을 늘리면 Lambda 함수가 동일한 메시지를 여러 번 처리하는 것을 방지할 수 있습니다. 이는 Lambda 함수가 완료되기 전에 다른 소비자가 메시지를 수신하지 않도록 합니다.

주요 용어 설명:

- SQS (Amazon Simple Queue Service): 메시지를 보내고 수신할 수 있는 완전 관리형 메시지 대기열 서비스입니다.

- Lambda (AWS Lambda): 코드를 실행할 서버를 프로비저닝하거나 관리할 필요 없이 애플리케이션 또는 백엔드 서비스를 구축할 수 있게 하는 이벤트 기반 서버리스 컴퓨팅 서비스입니다.

오답 분석:

- A: 긴 폴링을 설정해도 메시지가 여러 번 처리되는 문제를 해결하지 못합니다.

- B: SQS 표준 대기열을 FIFO 대기열로 변경하면 순서를 유지하지만 중복 호출 문제를 해결하지 않습니다.

- D: 메시지를 읽은 직후 삭제하면 메시지가 성공적으로 처리되지 않을 경우 손실될 수 있습니다.

✅ 문제 99

A company is implementing a shared storage solution for a gaming application that is hosted in an on-premises data center. The company needs the ability to use Lustre clients to access data. The solution must be fully managed.

Which solution meets these requirements?

회사는 온프레미스 데이터 센터에서 호스팅되는 게임 애플리케이션을 위한 공유 스토리지 솔루션을 구현하고 있습니다. 회사는 Lustre 클라이언트를 사용하여 데이터에 액세스할 수 있는 기능이 필요합니다. 솔루션은 완전히 관리되어야 합니다. 어떤 솔루션이 이러한 요구 사항을 충족합니까?

A.

Create an AWS Storage Gateway file gateway. Create a file share that uses the required client protocol. Connect the application server to the file share.

AWS Storage Gateway 파일 게이트웨이를 생성합니다. 필요한 클라이언트 프로토콜을 사용하는 파일 공유를 만듭니다. 응용 프로그램 서버를 파일 공유에 연결합니다.

B.

Create an Amazon EC2 Windows instance. Install and configure a Windows file share role on the instance. Connect the application server to the file share.

Amazon EC2 Windows 인스턴스를 생성합니다. 인스턴스에 Windows 파일 공유 역할을 설치하고 구성합니다. 응용 프로그램 서버를 파일 공유에 연결합니다.

C.

Create an Amazon Elastic File System (Amazon EFS) file system, and configure it to support Lustre. Attach the file system to the origin server. Connect the application server to the file system.

Amazon Elastic File System(Amazon EFS) 파일 시스템을 생성하고 Lustre를 지원하도록 구성합니다. 파일 시스템을 원본 서버에 연결합니다. 응용 프로그램 서버를 파일 시스템에 연결합니다.

D.

Create an Amazon FSx for Lustre file system. Attach the file system to the origin server. Connect the application server to the file system.

Lustre 파일 시스템용 Amazon FSx를 생성합니다. 파일 시스템을 원본 서버에 연결합니다. 응용 프로그램 서버를 파일 시스템에 연결합니다.

⭕ 정답: D

📝 해설

게임 애플리케이션을 위한 공유 스토리지 솔루션이 필요하며, Lustre 클라이언트를 사용해야 하고 완전 관리형 솔루션이 필요합니다. Amazon FSx for Lustre는 고성능 파일 시스템을 제공하며, Lustre 클라이언트를 지원하고 완전 관리형 솔루션입니다.

주요 용어 설명:

- Amazon FSx for Lustre: 고성능 컴퓨팅(HPC) 워크로드를 위한 완전 관리형 병렬 파일 시스템입니다.

- Lustre: 고성능 컴퓨팅 애플리케이션을 위해 설계된 오픈 소스 병렬 파일 시스템입니다.

오답 분석:

- A: AWS Storage Gateway는 주로 하이브리드 스토리지 솔루션으로 사용되며 Lustre를 지원하지 않습니다.

- B: EC2 Windows 인스턴스는 Lustre를 지원하지 않으며 완전 관리형 솔루션이 아닙니다.

- C: Amazon EFS는 Lustre를 지원하지 않습니다.

✅ 문제 100

A company's containerized application runs on an Amazon EC2 instance. The application needs to download security certificates before it can communicate with other business applications. The company wants a highly secure solution to encrypt and decrypt the certificates in near real time. The solution also needs to store data in highly available storage after the data is encrypted.

Which solution will meet these requirements with the LEAST operational overhead?

회사의 컨테이너화된 애플리케이션은 Amazon EC2 인스턴스에서 실행됩니다. 애플리케이션은 다른 비즈니스 애플리케이션과 통신하기 전에 보안 인증서를 다운로드해야 합니다. 회사는 거의 실시간으로 인증서를 암호화하고 해독할 수 있는 매우 안전한 솔루션을 원합니다. 또한 솔루션은 데이터가 암호화된 후 고가용성 스토리지에 데이터를 저장해야 합니다.

최소한의 운영 오버헤드로 이러한 요구 사항을 충족하는 솔루션은 무엇입니까?

A.

Create AWS Secrets Manager secrets for encrypted certificates. Manually update the certificates as needed. Control access to the data by using fine-grained IAM access.

암호화된 인증서에 대한 AWS Secrets Manager 암호를 생성합니다. 필요에 따라 인증서를 수동으로 업데이트합니다. 세분화된 IAM 액세스를 사용하여 데이터에 대한 액세스를 제어합니다.

B.

Create an AWS Lambda function that uses the Python cryptography library to receive and perform encryption operations. Store the function in an Amazon S3 bucket.

Python 암호화 라이브러리를 사용하여 암호화 작업을 수신하고 수행하는 AWS Lambda 함수를 생성합니다. 함수를 Amazon S3 버킷에 저장합니다.

C.

Create an AWS Key Management Service (AWS KMS) customer managed key. Allow the EC2 role to use the KMS key for encryption operations. Store the encrypted data on Amazon S3.

AWS Key Management Service(AWS KMS) 고객 관리형 키를 생성합니다. EC2 역할이 암호화 작업에 KMS 키를 사용하도록 허용합니다. 암호화된 데이터를 Amazon S3에 저장합니다.

D.

Create an AWS Key Management Service (AWS KMS) customer managed key. Allow the EC2 role to use the KMS key for encryption operations. Store the encrypted data on Amazon Elastic Block Store (Amazon EBS) volumes.

AWS Key Management Service(AWS KMS) 고객 관리형 키를 생성합니다. EC2 역할이 암호화 작업에 KMS 키를 사용하도록 허용합니다. 암호화된 데이터를 Amazon Elastic Block Store(Amazon EBS) 볼륨에 저장합니다.

⭕ 정답: C

📝 해설

컨테이너화된 애플리케이션이 보안 인증서를 다운로드하고 암호화/해독해야 합니다. 데이터는 고가용성 스토리지에 저장되어야 합니다. AWS KMS는 안전하게 인증서를 암호화 및 해독할 수 있으며, Amazon S3는 암호화된 데이터를 저장하기 위한 고가용성 스토리지 솔루션을 제공합니다.

주요 용어 설명:

- AWS KMS (Key Management Service): 데이터를 암호화 및 해독할 수 있도록 키를 생성하고 관리하는 서비스입니다.

- Amazon S3 (Simple Storage Service): 인터넷 스토리지 서비스로, 대규모 데이터 저장 및 관리를 위한 고가용성 스토리지 솔루션입니다.

오답 분석:

- A: AWS Secrets Manager는 주로 비밀을 저장하고 관리하는 데 사용되지만, 실시간 암호화/해독을 수행하는 데 적합하지 않습니다.

- B: Lambda 함수와 Python 암호화 라이브러리를 사용하면 추가적인 운영 오버헤드가 발생할 수 있습니다.

- D: EBS 볼륨은 EC2 인스턴스에만 연결될 수 있으며 고가용성 스토리지로 사용하기에는 적합하지 않습니다.

'Certificates > AWS-SAA-CO3' 카테고리의 다른 글

| [AWS SAA-C03] Examtopics Dump (121 - 140) (0) | 2024.05.22 |

|---|---|

| [AWS SAA-C03] Examtopics Dump (101 - 120) (0) | 2024.05.22 |

| [AWS SAA-C03] Examtopics Dump (61 - 80) (0) | 2024.05.22 |

| [AWS SAA-C03] Examtopics Dump (41 - 60) (0) | 2024.05.17 |

| [AWS SAA-C03] Examtopics Dump (21 - 40) (0) | 2024.05.17 |